O ProjektMagazin

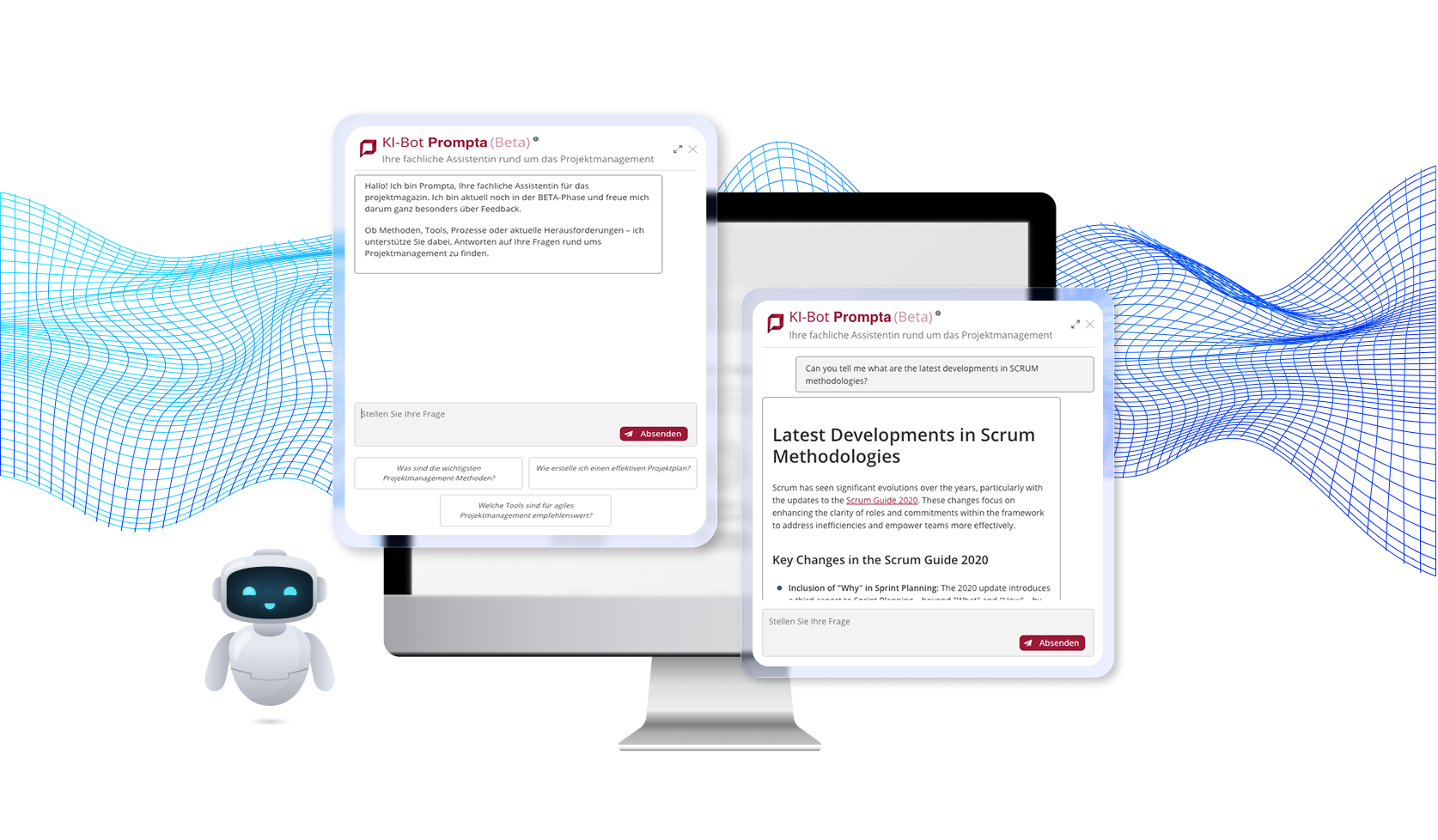

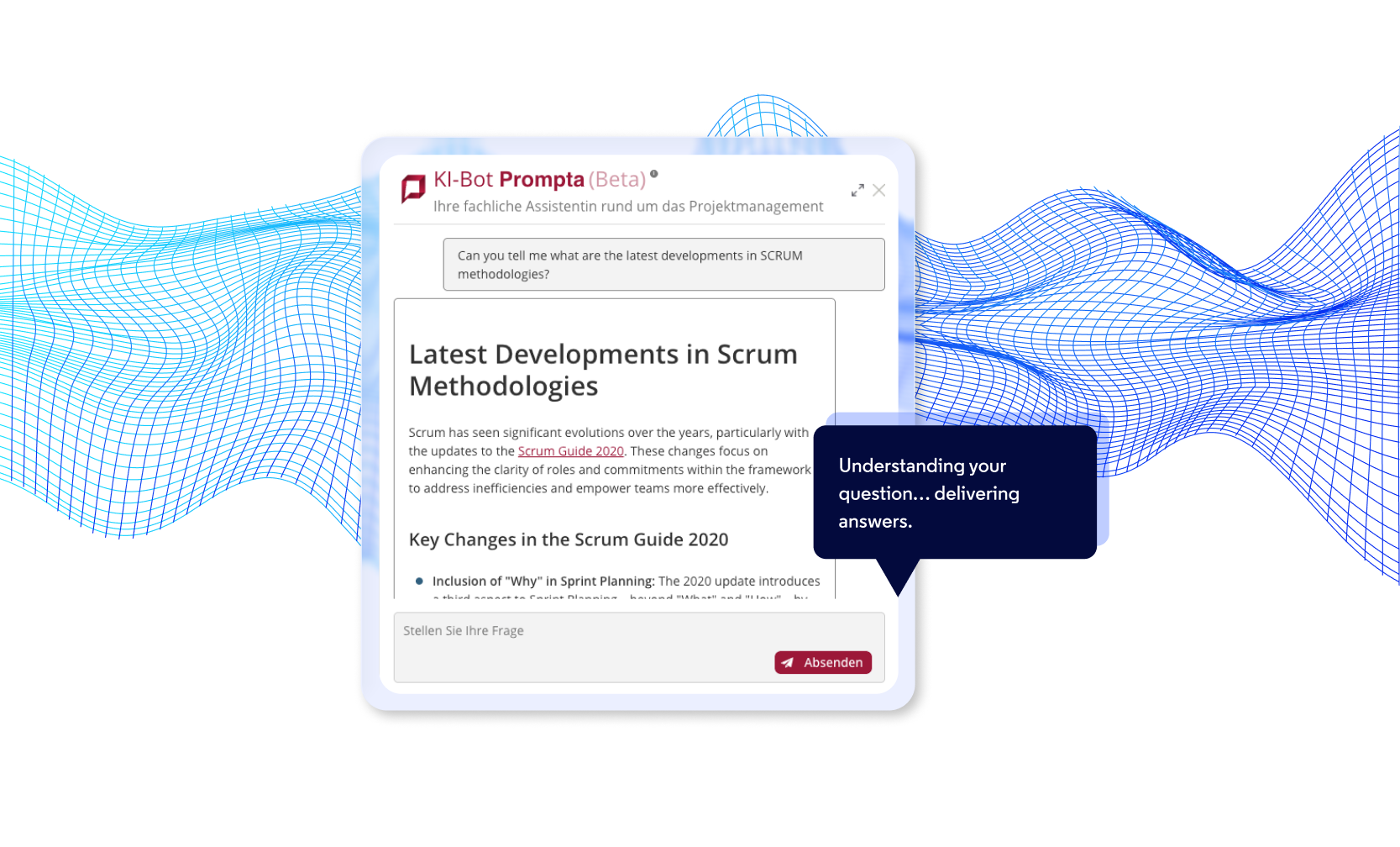

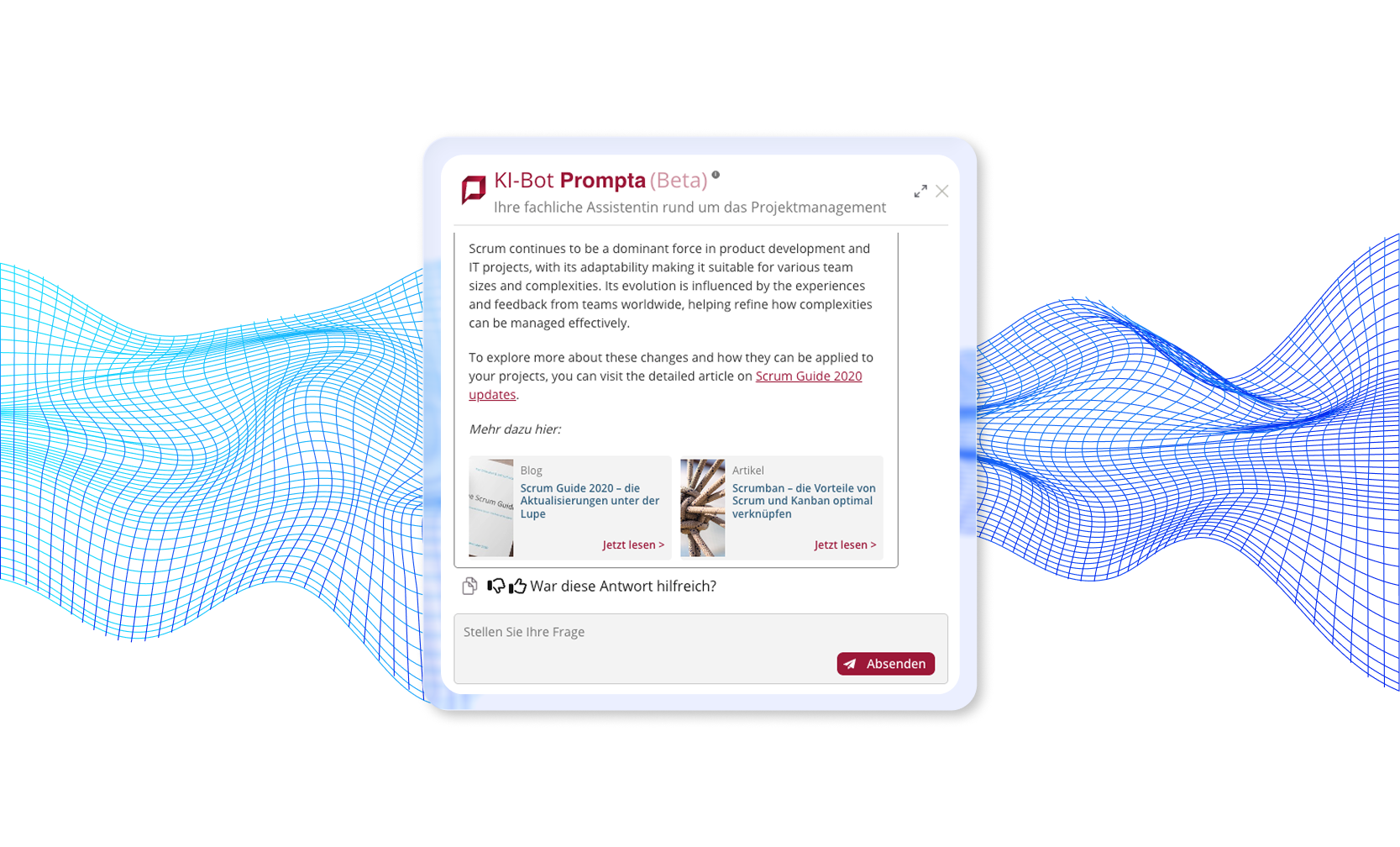

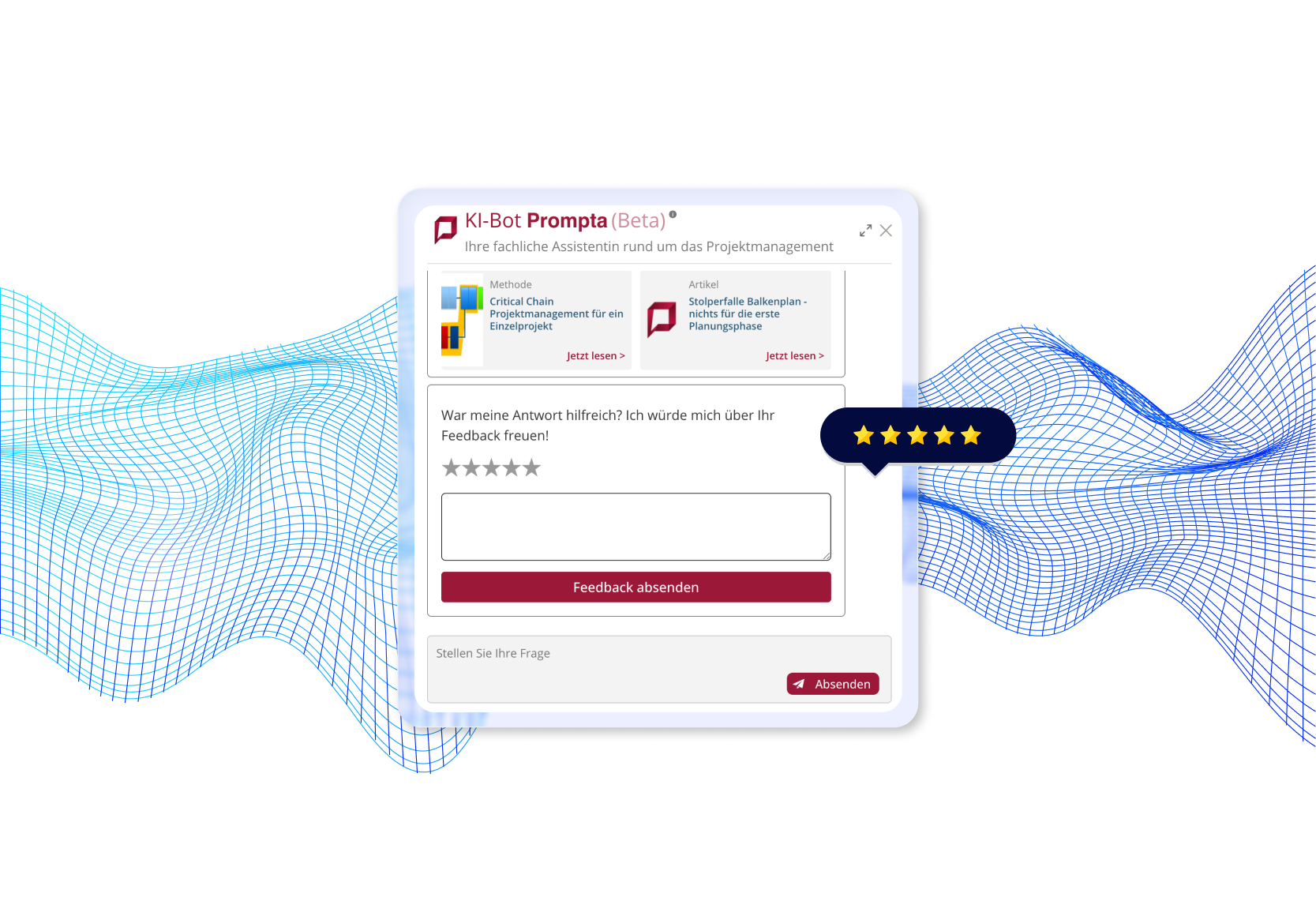

Co stworzyliśmy

Wpływ na biznes i usprawnienia operacyjne

Klient odnotował wysoki poziom satysfakcji użytkowników i już zidentyfikował ulepszenia wizualnego interfejsu jako kolejny etap usprawnień. Jest to wyraźny sygnał, że podstawowa funkcjonalność spełnia wszystkie jego potrzeby.

Wybór technologii

Wybraliśmy nasz zestaw technologii w oparciu o niezawodność produkcji, skalowalność i łatwość długoterminowego utrzymania.

Przeczytaj więcej o technicznych aspektach projektu na naszym blogu

W naszych artykułach opisujemy m.in., jak zadbaliśmy o aktualność wiedzy chatbota AI, jak dobieraliśmy narzędzia i frameworki do stworzenia stabilnego pipeline’u RAG oraz jakie techniki wykorzystaliśmy, aby skrócić czas odpowiedzi i zwiększyć precyzję generowanych rezultatów.